Big Social

{Anni al culmine di pericolosi algoritmi}

di Micaela Antozzi {Art Director}

di Micaela Antozzi {Art Director}

Nel film del 1998 in “The Truman Show”, Jim Carrey interpreta la star inconsapevole del suo reality show televisivo. Vive la sua vita nell’ignoranza di un universo artificiale – dal finto giornale del mattino, all’attrice che sposa – trascorrendo i suoi giorni in una “bolla di finzione” che gli è stata data in pasto fin da quando è nato. In realtà, tutto il suo mondo è contraffatto e controllato.

Come nella vita perfetta di Truman

“accettiamo la realtà del mondo così come ci viene propinata”.

Oggi, sui social media, tre miliardi di persone, sono tutte come Truman Burbank.

Sebbene pensiamo che queste piattaforme ci stiano collegando con il mondo, in realtà ci stanno separando dalla realtà. Ognuno di noi vive ed impara all’interno di una bolla personalizzata che cambia continuamente, radicalizzando inevitabilmente il nostro modo di comportarci.

I semi dell’odio sono già stati sparsi nell’etere, attraverso innumerevoli post, tweet e stream, riversandosi violentemente del mondo reale

Quello che è successo recentemente a Washington (Stati Uniti), è stato a dir poco epocale.

Per la prima volta dalla proclamazione dell’indipendenza nel 1776, un gruppo di cittadini ha preso d’assalto il palazzo del Congresso americano. Mentre senatori e deputati, riuniti per certificare l’elezione del nuovo presidente Joe Biden, i sostenitori del presidente uscente (e candidato sconfitto), hanno fatto irruzione per contestare il risultato elettorale.

Questi fatti sono stati definiti “l’attentato alla più importante democrazia del mondo”

Alimentate da false informazioni virali, molti di coloro che hanno perpetrato l’attacco a Capitol Hill sono stati trascinati, oltre che dallo stesso presidente uscente, da una ondata di pericolose teorie di complotto amplificate sui social media e i social media hanno offerto loro, uno strumento già pronto per propagare e mobilitare una folla violenta.

Quindi è abbastanza evidente che non è più possibile ignorare i risultati dell’estremismo e della polarizzazione indotti dagli algoritmi, poiché le conseguenze possono essere davvero catastrofiche.

Andrew Marantz, giornalista del The New Yorker, ha trascorso tre anni negli angoli remoti del web, frequentando nazisti, suprematisti bianchi e cospirazionisti, raccontando nel suo libro “Antisocial: Online Extremists, Techno-Utopians” le distopie del momento.

Questo libro rivela come i confini tra tecnologia, media e politica siano stati cancellati, dando luogo a un panorama informativo profondamente spezzato e in che modo in pochi anni, sfruttando la potenzialità delle piattaforme tecnologiche, gruppi ristretti di persone siano riuscite a coalizzare schiere urlanti e violente di reazionari e come i cinici propagandisti dell’alt-right abbiano sfruttato quella libertà, per spingere l’estremo nel mainstream.

Un rapporto interno di Facebook trapelato la scorsa estate e portato alla luce dal Wall Street Journal, riconosce che i loro algoritmi “sfruttano l’attrazione del cervello umano verso la divisione, Se lasciati deselezionati, questi algoritmi mutanti favorirebbero contenuti sempre più divisivi nel tentativo di attirare l’attenzione degli utenti e aumentare il tempo sulla piattaforma”.

La ricerca di Facebook ha rilevato inoltre che il 64%, di tutti gli utenti che si uniscono a un gruppo estremista sulla piattaforma, lo fa grazie agli strumenti di raccomandazione attraverso il proprio l’algoritmo (strumento con il quale il social network seleziona, suggerisce e determina cosa vedere e cosa no).

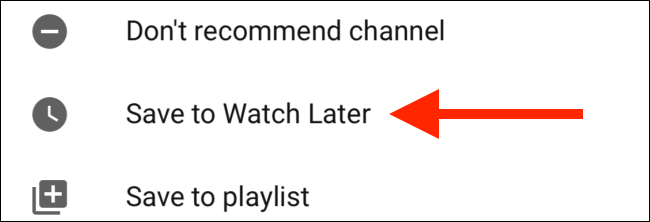

Ma anche l’algoritmo “guarda dopo” (watch later) di YouTube, ad esempio, potrebbe essere ancora più dannoso. Circa il 70% dei video che vediamo è stato consigliato dall’algoritmo del servizio, che è ottimizzato con l’obiettivo per farti guardare più video e annunci indipendentemente dal soggetto.

Questo darebbe la priorità a contenuti controversi che continueremo a guardare per curiosità, ma che una volta visionati, l’algoritmo presumerà che sia quello che ti interessa, guidandoti verso un tipo di cose che gli spettatori di quel video hanno scelto di guardare dopo.

Il che spiega il motivo per cui inizierai guardando un video relativamente innocuo di cucina, per finire a vedere dei video complottisti sulla teoria di QAnon.

Qualcuno ha detto che ci sono solo due modi per influenzare il comportamento umano: Il primo è manipolarlo, il secondo è ispirarlo.

Le fake news (notizie false) è un termine inglese per definire informazioni inventate, create per disinformare e rendere virali notizie attraverso internet. Con i social, queste amplificano il raggio di diffusione molto rapidamente, sia per scarsa informazione degli utenti e sia (diciamolo) per la pigrizia di cercare riscontri.

In un mio precedente articolo citavo “la camera dell’eco” (The Echo Chamber), un ambiente molto simile ad una rete di social media, in cui una persona incontra o legge solo notizie, credenze ed opinioni che coincidono esattamente e solo con le proprie, in modo che le idee alternative non vengano mai prese in considerazione e addirittura, rafforzandole e riecheggiandole a propria volta. Le Fake news si moltiplicano proprio in questo modo, riscuotendo un successo di massa e un grande effetto sulla coscienza della gente.

Nel grembo di Parler,

prima del blackout totale

In un mondo caratterizzato dalla proliferazione della disinformazione online e da cicli di notizie 24 ore su 24, gli hashtag sono importantissimi, poichè servono a correlare tutto ciò che è popolare su Internet in un determinato momento. E purtroppo la disinformazione attraverso la rete, tramite hashtag, si sviluppa proprio come un virus dannoso ed esponenziale.

Le fonti di disinformazione, prima del suo blackout, prosperavano in Parler, un’app mal progettata che ospitava una vasta gamma di incitamento all’odio, teorie di complotto, razzismo e minacce di violenza.

Gli utenti potevano cercare i post su Parler, tramite hashtag e non per il contenuto del testo all’interno del post stesso. Ciò ha portato gli utenti ad inserire hashtag in qualsiasi post che desideravano diffondere. Ad esempio la folle idea di uccidere i politici, è stata ampiamente discussa su Parler molto prima della rivolta del 6 gennaio al Congresso Americano. Il fatto grave è che questi post non sono mai stati moderati da nessuno, sia per negligenza che per ignoranza volontaria, diffondendosi viralmente e creando una vasta eco tra gli utenti della piattaforma.

Video con messaggi che evocano risposte violente come “impiccare i traditori”, “ucciderli tutti” si trovavano anche su Youtube e mentre lo stesso ultimamente, sembra abbia preso in considerazione, molto più seriamente, la moderazione dei contenuti, c’è stata una certa ipocrisia di Google nel bandire Parler dal proprio Google Play Store per incitamento all’odio, dopo aver ospitato un numero considerevole di video che inneggiavano a quella violenza, molti dei quali sono ancora presenti oggi.

“to be or not to be”

This is the (Social) dilemma

Alla fine di The Truman Show, il protagonista è costretto scegliere.

Può continuare la sua vita accettando la falsa realtà che gli è stata presentata o scegliere coraggiosamente di aprirsi alla verità.

Anche noi siamo di fronte a questo dilemma. Possiamo continuare a vivere in un universo sempre più estremo, distorto e pieno di illusioni, oppure consapevolmente, dobbiamo pretendere di scegliere qualcosa di meglio?

I Big Social. Anche loro saranno inevitabilmente di fronte ad una scelta: restare a guardare con compiacimento, le loro creazioni distruggere le democrazie oppure cercare di assumersi definitivamente le responsabilità per sistemare questo caos pieno di violenza e odio, che hanno contribuito a fomentare.